Die Details und der Anmeldelink für die APMB/SF-Praktika WS19/20 sind freigeschaltet.

Author: Admin

Prüfungsergebnisse und -einsicht GDI

Liebe Studierende,

die Ergebnisse der Prüfung Grundlagen der Informatik stehen nun in Campus und hängen am HLRS aus.

Die Prüfungseinsicht wird bereit diesen Freitag, 27.09., von 10-12 Uhr im Hilbertraum im HLRS, Nobelstraße 19 statt finden.

Hilbertraum: Gehen Sie im Foyer durch die Tür links, die Treppe hoch, dann durch die Tür nach rechts. Am Ende des Ganges auf der linken Seite befindet sich der Raum “Hilbertraum”.

Viele Grüße,

Michael Herrmann

Vorlesungsankündigung: Schnelle und genaue Multi-Domain Physics Simulation

Der Entwurf und die numerische Verifikation komplexer Aktoren und Sensoren einschließlich deren elektronischer Steuerung ist Gegenstand der vorliegenden Lehrveranstaltung. Die Unterteilung erfolgt in die wesentlichen Bereiche: CAD/CAE, Strukturmechanik, Elektrostatik, Elektromagnetik, Wärmeleitung, Strömungsmechanik und Fluid-Struktur-Wechselwirkung.

Allen Disziplinen gemeinsam ist die Einbettung in einen übergreifenden Systemsimulator, welcher die schritthaltende Berechnung von Regelkreisen mit Leistungs- und Signalelektronik ermöglicht.

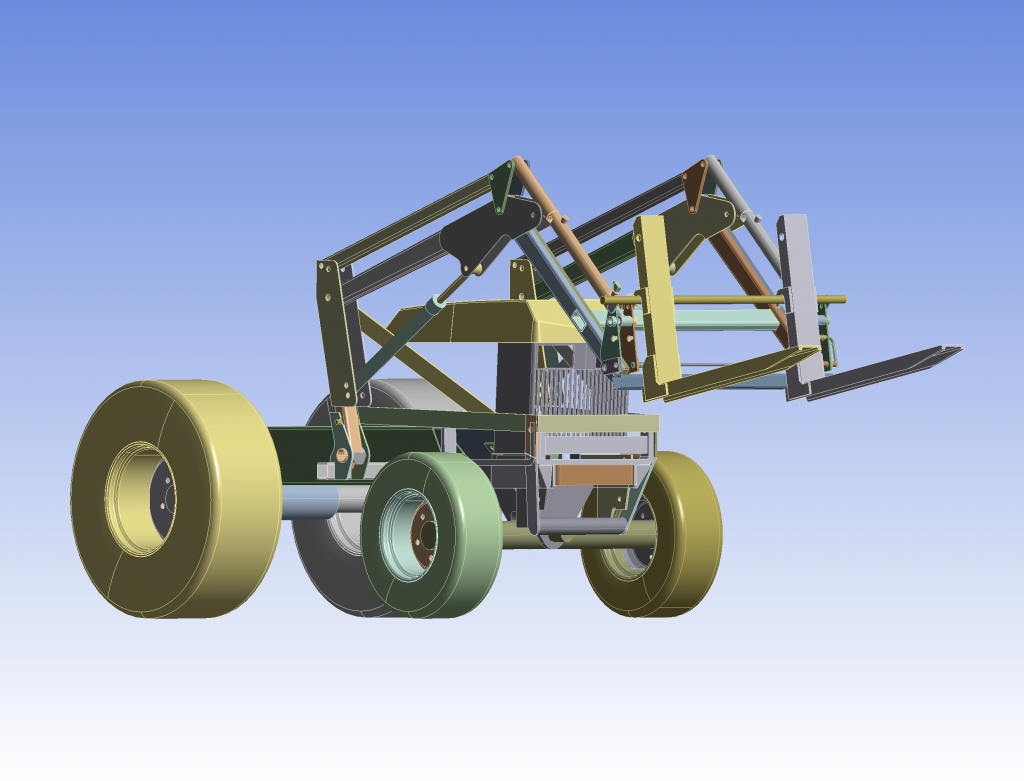

Strukturmechanik

CAD/CAE, Ansys Workbench, Materialmodellierung, Bewegungsgleichungen. Beispiele aus Maschinenbau, Verfahrenstechnik, Bauingenieurwesen. Vertiefung Frontlader:

Wärmeleitung

Wärmeübertragung, Wärmeleitung, Strahlung, Phasenübergänge. Materialmodellierung. Beispiele aus Induktorbau, Brandschutz.

Vertiefung Induktive Erwärmung:

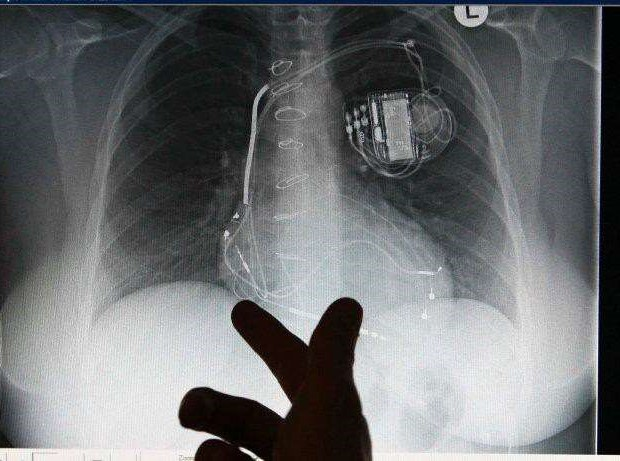

Systemsimulation

Systemsimulator Simplorer, Reduzierte Systemmodelle, Schaltkreissimulation in der Feldsimulation. Vertiefung Energyharvester zur Versorgung von Herzschrittmachern:

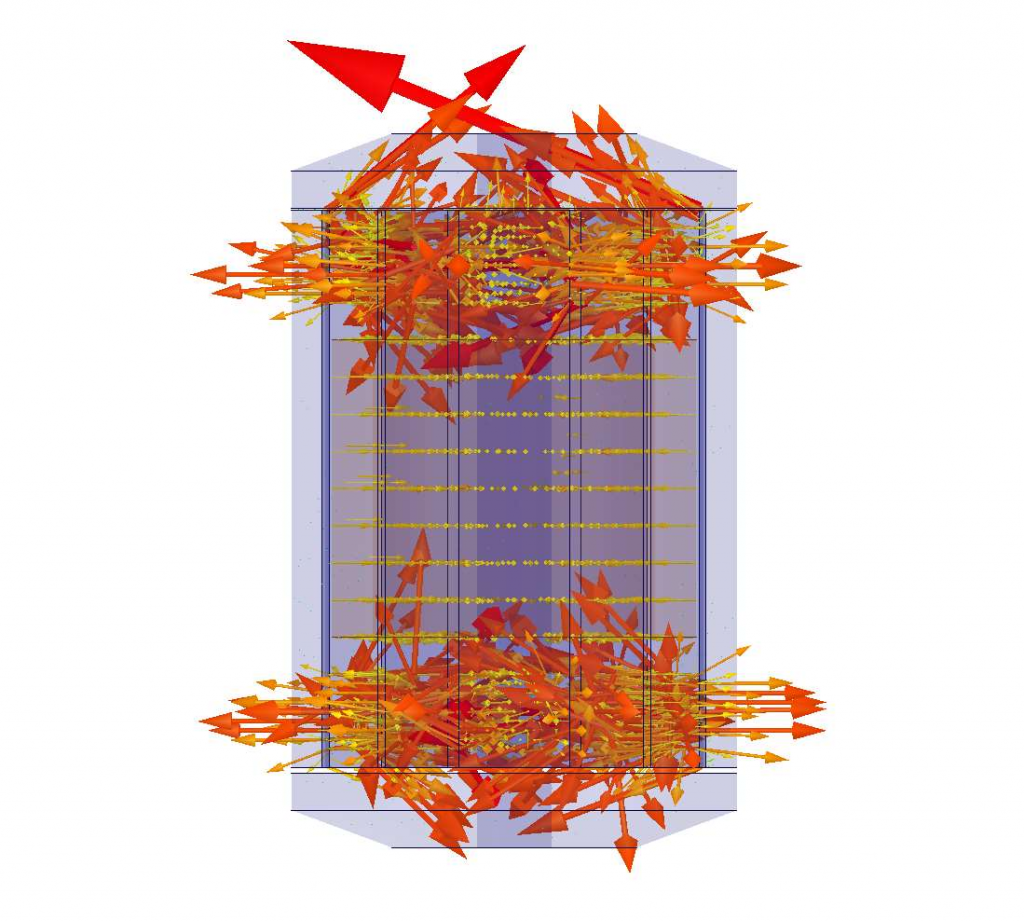

Elektromagnetik

Ansys Electronics Desktop, Maxwell-Gleichungen, Magnetwerkstoffe, Elektromagnetische Antriebe.

Vertiefung bistabiler Elektromagnet:

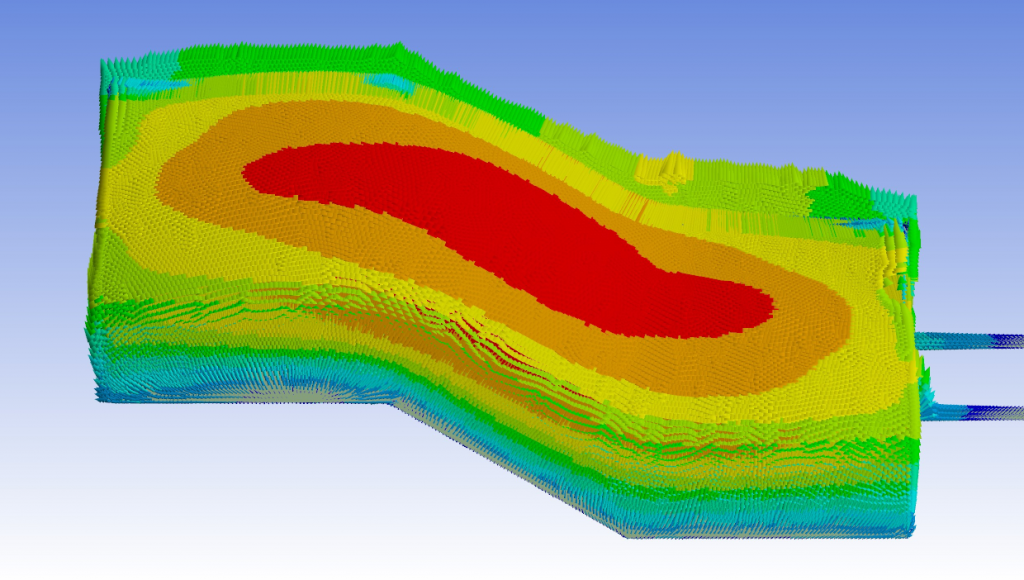

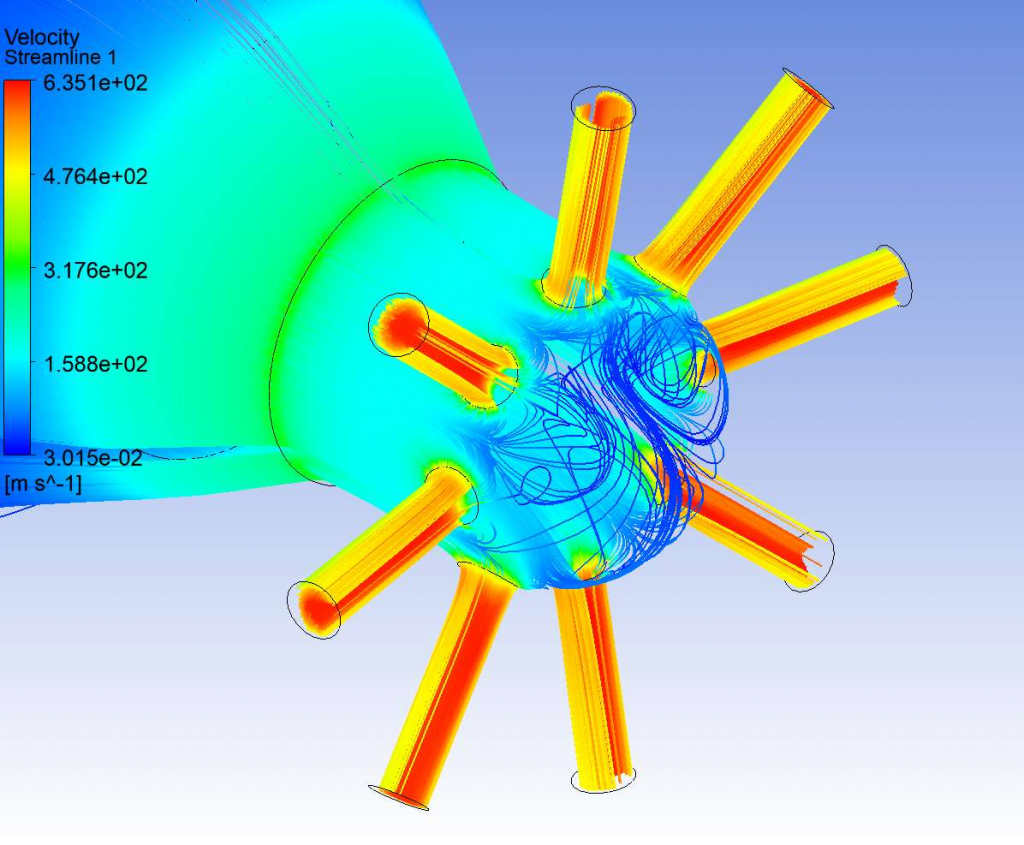

Strömungsmechanik

Mathematische CFD-Modelle. Instationäre Strömungen, Turbulenzmodelle, Mehrphasen- strömungen.

Vertiefung instationärer Kraftstoffinjektor:

Workflowautomatisierung

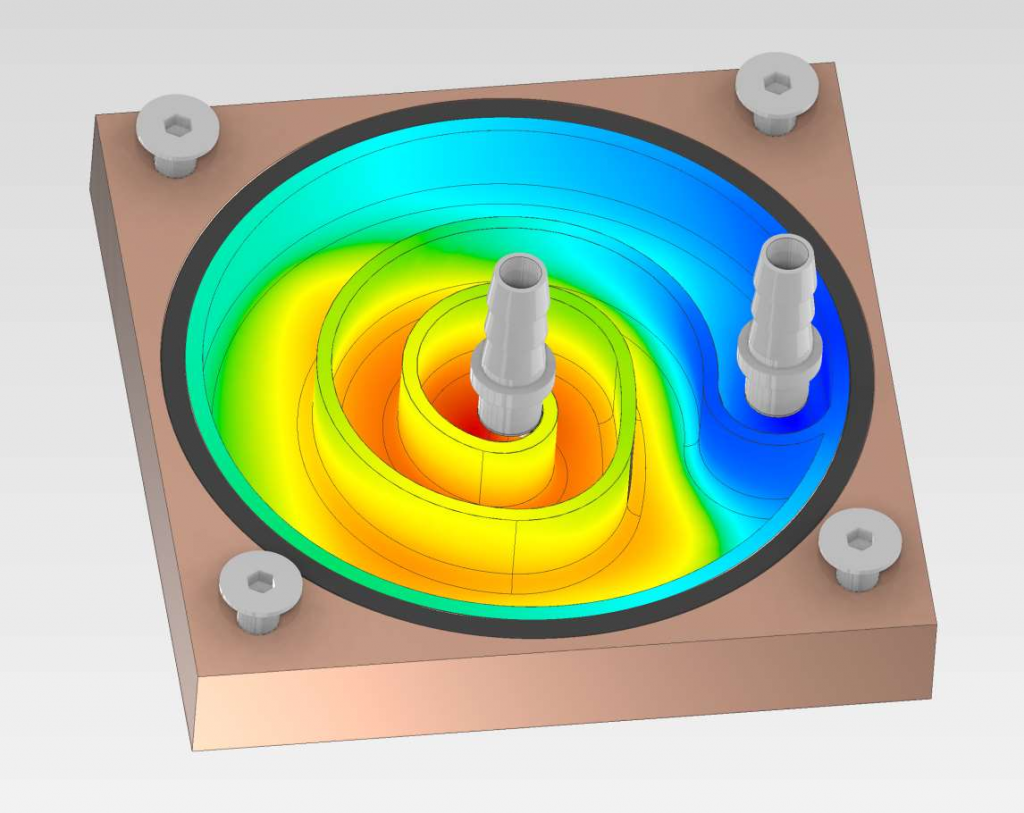

Ansys Discovery AIM. Simulation gekoppelter physikalischer Probleme in Echtzeit.

Vertiefung Wärmeregelung für CPU-Coldplate:

Interdisziplinäre Probleme

Bidirektionale Kopplungen der o.g. physikalischen Domänen.

Vertiefende Informationen:

MDPS Teil1 (.pdf)

MDPS Teil2 (.pdf)

Lehrmaterialien:

PDF-Textbuch, Akademische Simulationssoftware, 32 Übungen.

Schriftliche Prüfung:

Gegenstand sind Übungsaufgaben der Strukturmechanik.

LV-Beschreibung:

LV-Titel: Schnelle und genaue Multi-Domain Physics Simulation

LV-Nummer, LV-Art: 360705100, Vorlesung

Semesterstunden: 2 Vorlesung / 0 Übung (Wintersemester)

Kontakt: Haas, Peter-Wilfried, Resch, Michael

Abschlussvortrag Studienarbeit

Am Freitag, den 30.08.2019, wird Herr Hai Nam Ngo den Abschlussvortrag seiner Studienarbeit über das Thema “Entwicklung eines strukturmechanischen Simulationsmodells zur Spannungsanalyse in der Lendenwirbelsäule” halten.

Der Vortrag findet um 13:00 Uhr im Raum Berkeley Shanghai im HLRS, Nobelstraße 19 statt.

Masterarbeit zu vergeben

LiDAR Sensorsimulation

zur Validierung autonomer Fahrfunktionen bei Bosch

Für mehr Informationen finden Sie hier die Ausschreibung:

Termine APMB 2019

Die Themen und Termine der Praktika im Sommersemester 2019 finden Sie unter ‘Praktika’. Der Link zur Anmeldeseite ist freigeschaltet.

Noten der Prüfung MSO I

Liebe Studierende,

wir haben die Klausur MSO I korrigiert. Die Noten hängen ab jetzt am HLRS an der Schautafel aus.

Die Prüfungseinsicht findet am 25.03. und 26.03.2019 von 13:00 – 14:00 Uhr in der Nobelstr. 19, Raum Hilbert* statt.

*Wegbeschreibung: Sie betreten das Foyer des HLRS und gehen durch die Türe auf der linken Seite. Dann die Treppen nach oben, dann durch die Türe und nach rechts abbiegen. Der letzte Raum auf der linken Seite ist der Hilbertraum.

BA oder MA Arbeit zu vergeben

Implementierung einer automatisierten

Metadatenerfassung im HPC-Umfeld

Forschungsdatenmanagment in den Ingenieurwissenschaften steht vor einigen Herausforderungen, insbesondere die Größe der Daten sowie deren Verwaltung ist problembehaftet. Auch heutzutage werden die im Forschungsprozess anfallenden, durch Simulation erzeugten Forschungsdaten, die z.B. Trajektorien von Molekülen oder Strömungsverhalten repräsentieren, oft nur über Datei- oder

Verzeichnisnamen verwaltet, was sich zusehens als unzureichend herausstellt.

Für zielgerichtetes Forschungsdatenmanagement unabdingbar ist die Benutzung von Metadaten. Metadaten sind Daten über Daten und beschreiben diese von höherer Ebene ausgehend inhaltlich.

Metadaten sind eine der wesentlichen Voraussetzungen, Daten FAIR (Findable, Accessible, Interoperable, Re-usable) [1] bereitzustellen. Das Projekt DIPL-ING [2] hat sich zum Ziel gesetzt, Konzepte und Lösungen für das Forschungsdatenmanagement in den Ingenieurwissenschaften zu entwickeln und Daten FAIR zu machen. Innerhalb des Projekts wurde das Metadatenmodell EngMeta für die Thermound Aerodynamik entwickelt [3]. Als eine der wesentlichen Anforderungen für gelingendes Forschungsdatenmanagement kristallisierte sich die automatisierte Erfassung von Metadaten heraus sowie die Nutzung eines zentralen, fachspezifischen Repositoriums.

Ziele und Aufgaben

Im Rahmen der Arbeit, welche sowohl als Bachelor- als auch als Masterarbeit ausgestaltet werden kann, sollen 1. die automatisierte Erfassung von Metadaten weiterentwickelt und 2. Schnittstellen zum

Repositorium (Dataverse) erstellt und programmiert werden.

– Erweiterung der automatisierten Erfassung von Metadaten: Ein bestehendes, prototypisches auf

Java/Spark basierendes und für Gromacs-Dateien aus thermodynamischer Simulation ausgelegtes System soll weiter implementiert werden. Dies umfasst einerseits die Erweiterung auf andere Dateiformate (aus Simulationspaketen der Aerodynamik). Andererseits soll die

prototypische Implementierung möglichst in eine systemnahe, native und leichtgewichtige Implementierung überführt werden.

– Anpassung und (Weiter)-Entwicklung des Dataverse Clients (Java), so dass Daten und Metadaten auf dem Dateisystem in der Höchstleisungsrechnerumgebung am HLRS in das universitätsweite Repositorium für Forschungsdaten geschrieben und wieder empfangen werden können. Dazu muss der Dataverse-Client zunächst auf seine bestehende Funktionalität hin analysiert und ggf. erweitert und angepasst werden.

Schließlich müssen die Ergebnisse in einer schriftlichen Ausarbeitung, die wissenschaftlichen Standards genügen und sich nach den allgemeinen Bestimmungen im jeweiligen Fachbereich richten muss, vorgelegt werden. Außerdem muss die Arbeit in einem Vortrag vorgestellt werden.

Anforderungen

Der/Die Berarbeiter/in bringt Linux-Kenntnisse mit, die auch Shell-Scripting umfassen. Außerdem werden Kenntnisse in der Sprache Java vorausgesetzt. Idealerweise wird das Profil ergänzt durch Kenntnisse im Bereich Simulation und Benutzung von Cluster-Systemen.

Betreuer:

Dipl.-Inf. Björn Schembera

Prof. Dr.-Ing. Michael M. Resch

Ausgabe und Kontakt:

ab sofort, bei Interesse oder Fragen bitte an Herrn Björn Schembera (schembera@hlrs.de) wenden.

Referenzen

[1] Wilkinson, M.D., Dumontier, M., Aalbersberg, I.J., Appleton, G., Axton, M., Baak, A., Blomberg, N., Boiten, J.W., da Silva Santos, L.B., Bourne, P.E., et al.: The fair guiding principles for scientific data management and stewardship. Scientific data 3 (2016)

[2] https://www.hlrs.de/about-us/research/current-projects/dipl-ing/

[3] Schembera, Björn und Dorothea Iglezakis (2018). „The Genesis of EngMeta – A Metadata Model for Research Data in Computational Engineering“. In: Metadata and Semantic Research. 12th International

Conference, MTSR 2018, Limassol, Cyprus, 23-26 October 2018, Proceedings. Springer.

Masterarbeit zu vergeben

Masterarbeit:

Analyse und Optimierung der Parallelisierungsstrategie des Mehrgitterlösers in FS3D

Zielsetzung:

Das Programmpaket Free Surface (FS3D) ist ein am ITLR entwickelter Code zur Direkten Numerischen Simulation (DNS) von Mehrphasenströmungen mit Hilfe der Volume-of-Fluid (VOF) Methode. FS3D wird zum Beispiel zur Simulation von Phasenwechselvorgängen oder tropfendynamischer

Prozesse eingesetzt. Die bei diesen Simulationen notwendige, sehr hohe räumliche Auflösung macht es unerlässlich die anfallende Rechenlast auf eine große Anzahl an Prozessoren zu verteilen. FS3D verwendet zur Parallelisierung das Message Passing Interface (MPI).

Zur effizienten Lösung der Druckausbreitung kommt ein Mehrgitterlöser zum Einsatz. Analysen der Performance von FS3D zeigen, das im Bereich der Implementierung des Mehrgitterlösers Optimierungspotenzial besteht.

Im Rahmen dieser Arbeit soll die Parallelisierungsstrategie der bestehenden Implementierung des Mehrgitterlösers analysiert und auf Basis dieser Analyse eine neue, effizientere Parallelisierungsstrategie erarbeitet werden.

Im Anschluss daran ist die Performance der neuen Parallelisierungsstrategie zu analysieren und mit der bestehenden Parallelisierungsstrategie zu vergleichen.

Arbeitsschritte:

– Einarbeitung und Analyse der bestehenden Implementierung des Mehrgitterlösers

– Literaturrecherche zu Implementierung von parallelen Mehrgitterlösern

– Entwicklung einer effizienten Parallelisierungsstrategie für den Mehrgitterlöser in FS3D

– Implementierung der entwickelten Parallelisierungsstrategie des Mehrgitterlösers in FS3D

– Analyse der Performance der neu implementierten Parallelisierungsstrategie des Mehrgitterlösers und Vergleich mit der bestehenden Implementierung

– Schriftliche Dokumentation und Diskussion der Ergebnisse

Voraussetzungen:

– Grundkenntnisse in Linux und Fortran

Betreuer:

– Prof. Dr.-Ing. Michael M. Resch

– Dipl.-Ing. Philipp Offenhäuser (offenhaeuser@hlrs.de), HLRS

– Dipl.-Ing. Martin Reitzle, ITLR

– Toni Peter, M.Sc., HLRS

Ausgabe: ab sofort, bei Interesse bitte Philipp Offenhäuser (offenhaeuser@hlrs.de) kontaktieren

Studienarbeit am HLRS zu vergeben

Analyse (Data Analytics) von Lustre-Performance-Daten zur

Identifizierung von I/O-kritischen HPC-Applikationen

Das Schreiben und Lesen von großen Datenmengen kann bei

parallelen Simulationsprogrammen ein signifikantes Bottleneck

darstellen. Weil das Dateisystem eine Ressource ist, die sich

alle Benutzer teilen, kann ein falsch implementiertes I/O (Input/

Output) Verfahren negative Auswirkungen auf die I/O Perfomance

der Berechnungsjobs anderer Benutzer haben.

Am HLRS wurde ein Framework für das Monitoring der parallelen

Dateisysteme entwickelt. Dieses Framework sammelt I/O Performance-

Daten (z.B. die Bandbreite beim Lesen/Schreiben pro Job) zu den Applikationen die auf den HPC-Systemen des HLRS ausgeführt werden.

Ziel der Arbeit ist es aus den I/O-Performance-Daten

Applikationen mit Optimierungspotenzial im Bereich der I/O zu

identifizieren. Dafür werden im ersten Schritt Filterkriterien

aufgestellt, um relevante Berechnungsjobs (z.B. großer Hardware-Ressourcenverbrauch) zu identifizieren.

Im zweiten Schritt werden Metriken zur Bewertung der I/OPerformance

aufgestellt mit denen Applikationen mit Optimierungspotenzial identifiziert werden können. Im letzten Schritt werden die Filterkriterien und Performance-Metriken anhand verschiedener Datensatz analysiert und bewertet.

Arbeitsschritte:

• Literaturrecherche

• Einarbeitung in das bestehende Framework zur Lustre-Leistungsanalyse

• Aufstellen von Kriterien zur Reduzierung der Daten

• Aufstellen von Metriken zur Bewertung der I/O-Performance

• Evaluierung der Filterkriterien und der Performance-Metriken

• Schriftliche Dokumentation und Diskussion der Ergebnisse

Voraussetzung:

• Grundkenntnisse in Linux und Python

Betreuer:

• Prof. Dr.-Ing. Michael M. Resch

• Philipp Offenhäuser (offenhaeuser@hlrs.de)

• Holger Berger (NEC)

• Thomas Beise

Ausgabe: Ab sofort, bei Interesse bitte Philipp Offenhäuser (offenhaeuser@hlrs.de) kontaktieren.